【

儀表網 研發快訊】近日,中國科學院上海微系統與信息技術研究所仿生

視覺系統實驗室李嘉茂研究員團隊在視覺三維人體姿態估計領域取得了重要進展。題目為“Rotated Orthographic Projection for Self-Supervised 3D Human Pose Estimation”的成果被機器視覺領域頂級三大國際學術會議之一European Conference on Computer Vision(ECCV)2024錄用。

三維人體姿態估計是機器視覺理解人體動作的關鍵技術,在虛擬現實、運動分析、人機交互等領域有著廣泛應用。直接獲得高精度的三維人體姿態成本較高,機器視覺領域往往利用人工神經網絡進行自監督學習,從多視角的二維圖像中預測三維人體姿態。

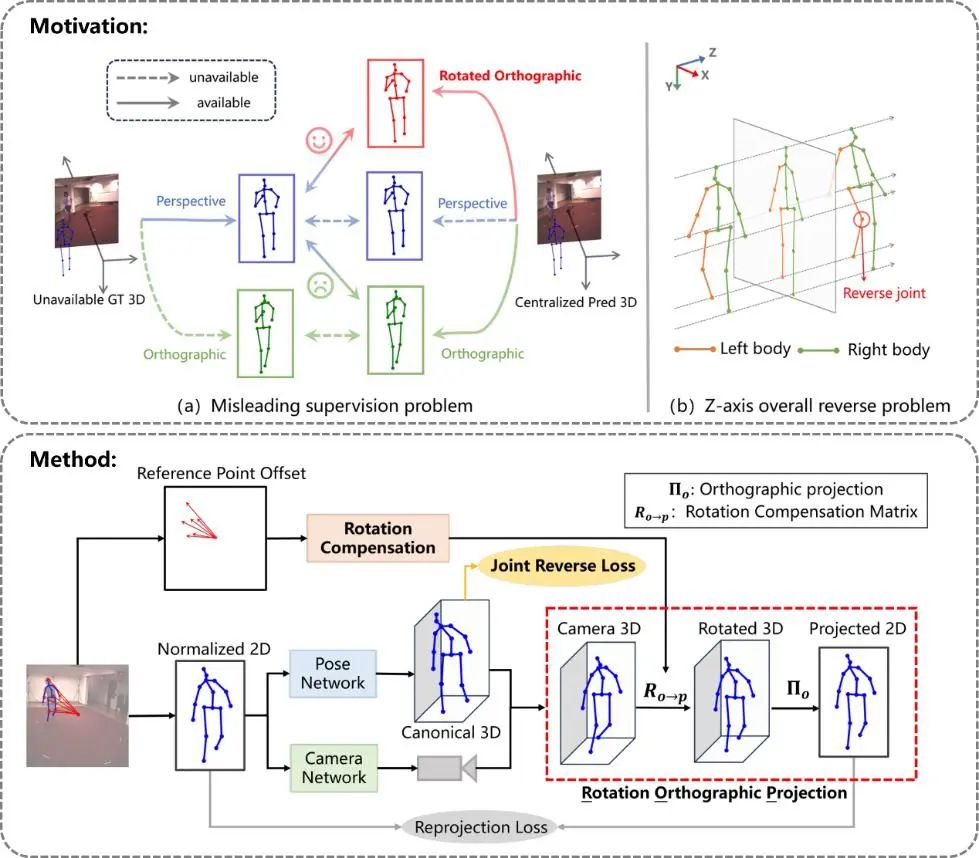

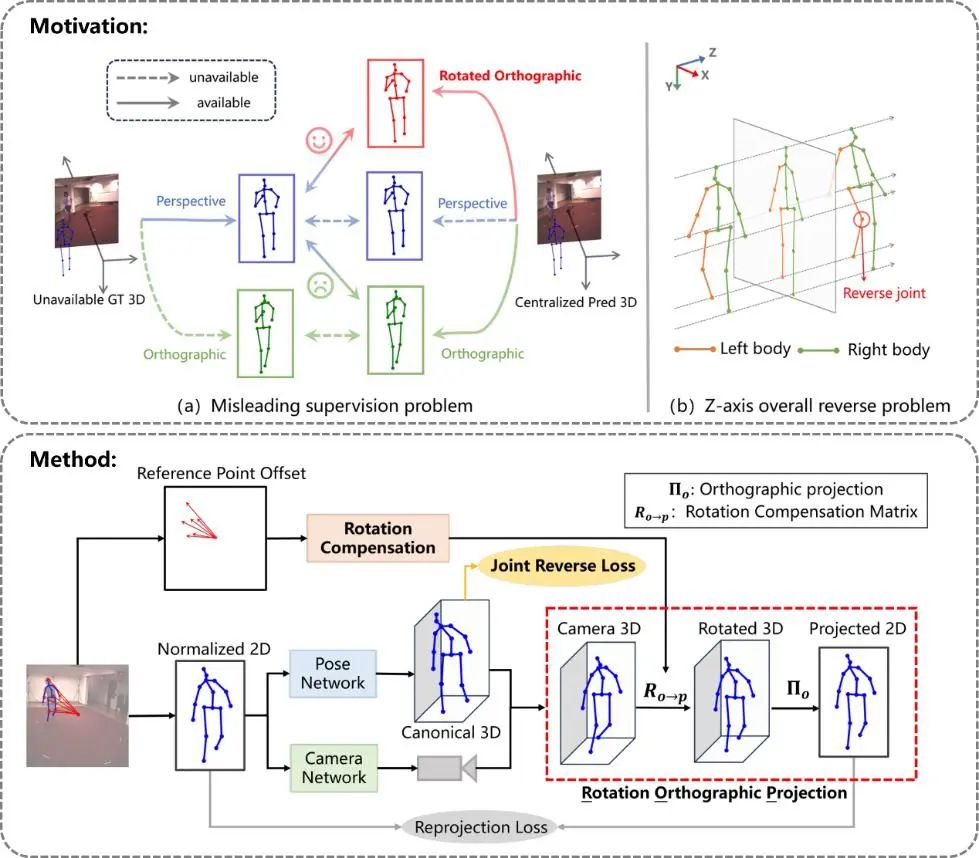

重投影一致性,是實現自監督學習3D人體姿態的關鍵。其主要思想是,由虛擬相機從與預測到的3D人體姿態拍攝到的2D人體姿態,應該與輸入圖像中直接得到的2D人體姿態一致。在實際操作中,輸入圖像的2D姿態是由相機成像的透視投影得到的,然而由于與圖像相匹配的相機參數等信息缺失,預測的3D姿態無法使用透視投影,現有研究多采用簡化投影模型-正交投影近似獲得2D人體姿態。這兩種投影模型的差異導致人工神經網絡的學習與預測之間出現了偏差,3D人體姿態估計存在不可避免的誤差問題。此外,重投影一致性約束缺乏對三維空間中姿態Z軸方向的有效約束,即使預測三維姿態Z軸整體反向,預測姿態的二維投影與輸入二維姿態仍能保持一致,這嚴重損害了模型的穩定性。

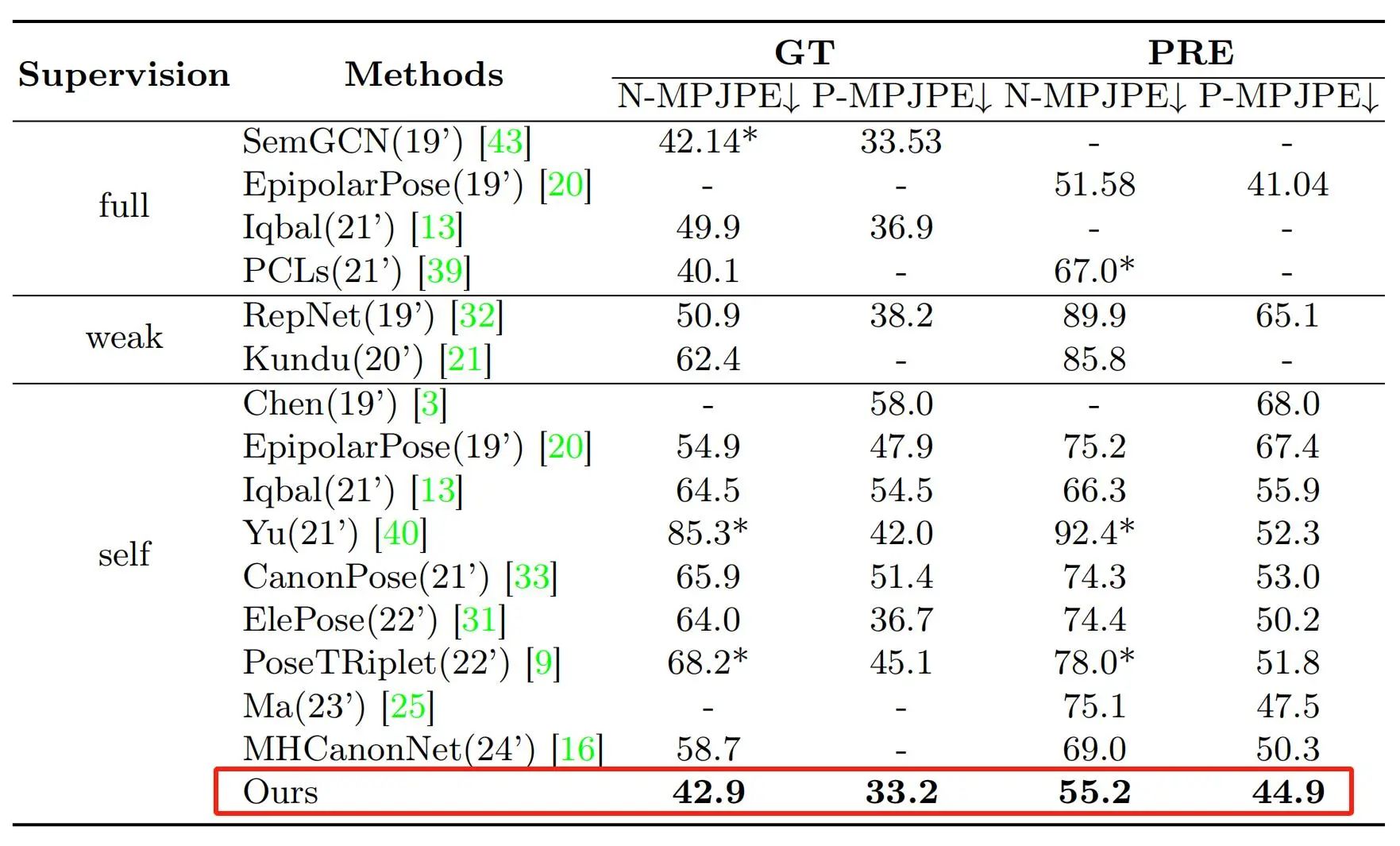

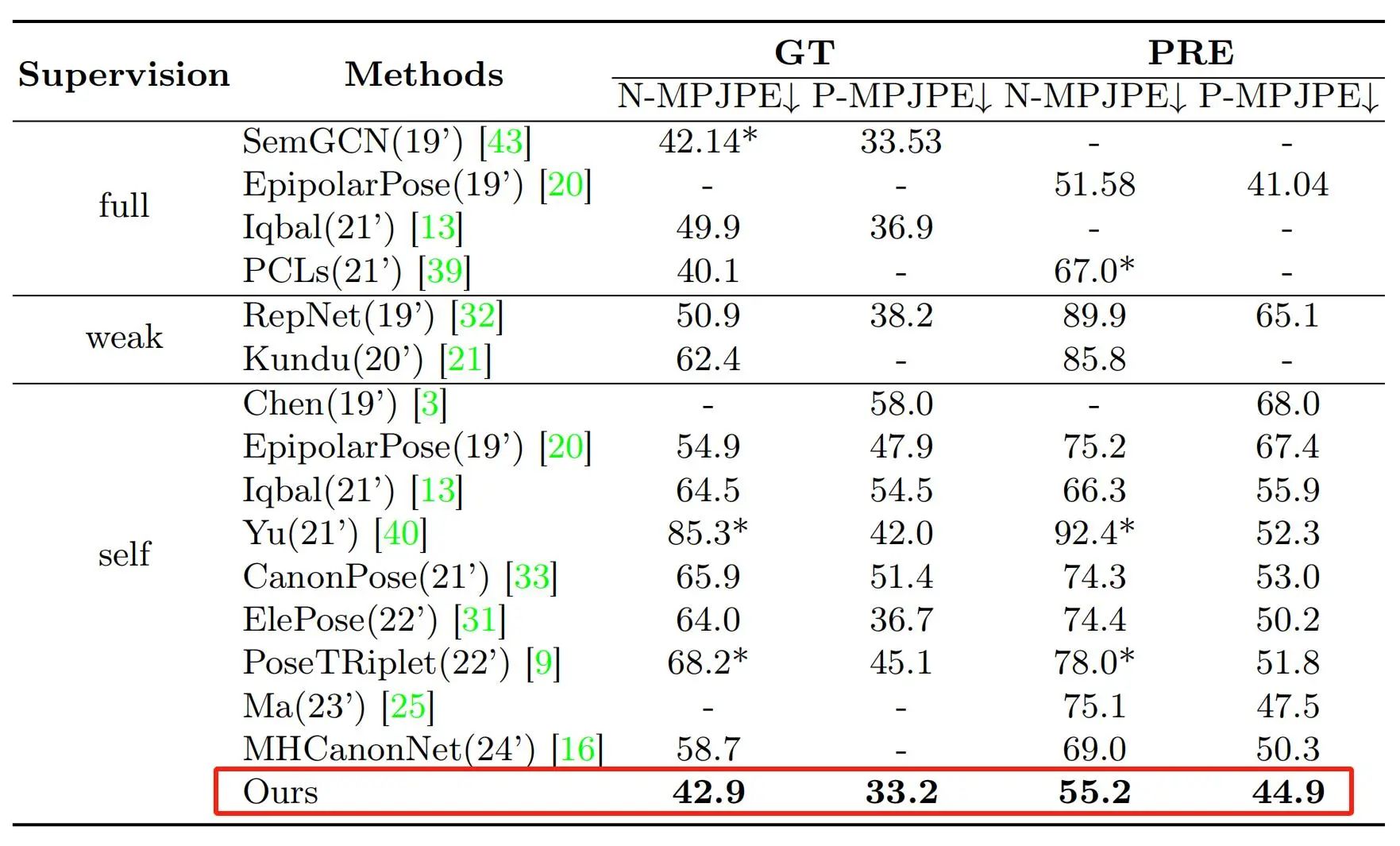

為解決上述問題,團隊提出了一種旋轉正交投影模型,通過增加一個根據參考點距離圖像中心的偏移計算的旋轉補償,來實現對透視投影的幾何近似,在保持投影模型簡單的同時縮小與透視投影模型之間的誤差。并在此基礎上根據人體結構對參考點的選取進行了優化,提出了分組旋轉正交投影方法,即根據關節點之間的相對距離將人體分割成多個部分,并分別計算參考點和相應的旋轉補償,進一步縮小了與透視投影模型的誤差。對于姿態Z軸整體反向問題,團隊提出了關節反向約束,利用骨骼運動學先驗增強對三維空間中人體姿態的監督,彌補二維監督的不足。本方法在三維人體姿態威評測數據集Human3.6M上完成了驗證,達到了平均誤差42.9 毫米的最優性能,相比基線自監督方法(CanonPose)提高了34.9%。

團隊三維人體姿態估計方法在Human3.6M數據集上達到最優性能

本研究成果得到了科技部科技創新2030、國家自然科學基金、上海市自然基金、中國科學院青促會、上海市優秀學術帶頭人等項目支持。上海微系統所仿生視覺系統實驗室研究生姚瑤為論文第一作者,李嘉茂研究員為通訊作者。

所有評論僅代表網友意見,與本站立場無關。